Eine Explainable AI schafft stärkeres Vertrauen in Künstliche Intelligenz. In vielen Bereichen liefert eine KI zwar bessere Ergebnisse, doch wie sie dazu kommt, findet in der sogenannten „Black Box statt“. Das bedeutet, dass man der KI Daten gibt und diese ein Ergebnis zurückliefert. Der Weg dorthin bleibt jedoch unklar – wie in einer schwarzen Box, in der theoretisch alles Mögliche stattfinden könnte.

Die Explainable AI versucht diese Blackbox transparenter zu machen, indem sie ihre Entscheidungen auch erklärt. Doch was auf der einen Seite Vertrauen schafft, hat ebenso Nachteile. Wir zeigen euch, was eine KI erklärbar macht und wo dies die Möglichkeiten einer Künstlichen Intelligenz eventuell einschränkt.

Was ist eine Explainable AI überhaupt?

Eine Explainable AI bzw. Erklärbare KI ist eine Künstliche Intelligenz, dessen Entscheidungen transparent erklärt sind. Das bedeutet, dass beispielsweise Erklärungswege sichtbar sind oder auch das Material, mit dem die KI trainiert wurde einsehbar ist. Letzteres ist wichtig, weil eine unausgewogene Datengrundlage etwa dafür sorgen kann, dass die Künstliche Intelligenz einseitig geschult ist oder Vorurteile entwickelt. Zu dem Problem haben wir übrigens auch einen eigenen Artikel veröffentlicht.

Explainable AI ist herausfordernd für Deep Learning

Beim Deep Learning lernt eine Künstliche Intelligenz in Form eines vereinfacht dargestellten menschlichen Gehirns. Es nimmt eine Vielzahl von Informationen, erkennt darin Muster für mögliche Ergebnisse und gewichtet diese Muster, um immer zuverlässigere Ergebnisse zu erzielen.

Diese neuronalen Netze sind ein Meilenstein was die KI-Entwicklung angeht. Zuvor mussten Entwickler der KI quasi vorschreiben, welche Muster zu welchem Ergebnis gehören, nun kann sich die KI das selbstständig beibringen. Sie erkennt dadurch auch viel schneller Muster, die man als Entwickler gar nicht richtig beschreiben könnte. Die erkennen KIs bei Krankheitsdiagnosen unter anderem Muster, die Medizinern noch nicht bewusst waren, da sie nicht so viele Daten nebeneinander bis aufs kleinste Detail auswerten können, wie eine Künstliche Intelligenz.

Doch wenn Datenmuster zu komplex sind, um sie programmatisch zu beschreiben, wird es zugleich auch schwieriger umgekehrt diese Muster in eine für den Menschen verständliche Erklärung zu übersetzen.

Je komplexer das neuronale Netzwerk, desto schwieriger ist nachzuvollziehen, welche Muster die KI überhaupt erkennt. Zugleich wird die KI durch die Komplexität aber auch zuverlässiger, da sie mehr Informationen vielschichtiger verknüpft. Es gibt Fälle, in denen das neurale Netz zu komplex ist und wir der Künstlichen Intelligenz einfach vertrauen müssen. Eine Explainable AI bedeutet jedoch auch nicht immer, dass das Handeln der KI allgemeinverständlich beschrieben wird. Es gibt auch andere Wege, eine erklärbare KI zu erschaffen.

Wie wird eine Künstliche Intelligenz eine Explainable AI?

Wie man eine KI nachvollziehbar macht, hängt sehr stark davon ab, wofür sie eingesetzt wird. Geht es beispielsweise um automatisierte bürokratische Vorgänge, kann eine Explainable AI sich sehr einfach auf einzelne Posten beziehen. Bei Nichtbewilligung eines Antrages kann sie beispielsweise bestimmte Angaben nennen und mit statistischen Bezügen begründen. Noch besser ist es aber, wenn die KI zugleich Tipps gibt, wie der nächste Antrag bewilligt wird.

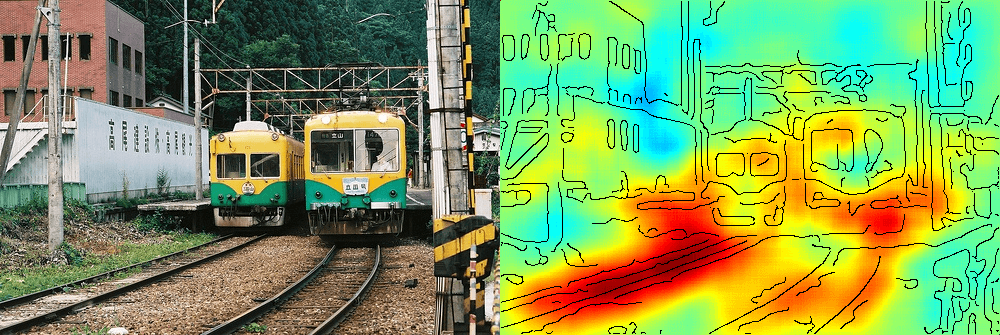

Schwieriger wird das ganze schon bei Bilderkennung, da zu jedem Pixel gleich mehrere Informationen vorhanden sein können. Die Künstliche Intelligenz könnte für das Ergebnis eine Heatmap anbieten, welche die zur Erkennung relevantesten Bereiche des Bildes zeigt. Während die Erkennung eines Tieres meist nicht viel Erklärung bedarf, gibt es auch abstraktere Anwendungsfälle. Ärzte können womöglich selbst von der KI lernen, welche Bereiche für die Diagnose der Explainable AI relevant waren.

Wichtig ist die Erklärbarkeit auch dann, wenn eine KI moralische Entscheidungen zu treffen hat. Das wäre beim Autonomen Fahren im schlimmsten Fall die Entscheidung, wer bei einem nahezu unausweichlichen Unfall sterben müsste. Schon gerichtlich ist dann eine Explainable AI wichtig, die ihr Analyse möglichst nachvollziehbar dokumentiert. Beweisbilder gibt es ohnehin, aber trotzdem ist es wichtig wie die KI Größe von Menschengruppen, Alter und andere Faktoren berücksichtigt hat. Zudem dürfen manche Faktoren je nach Gesetz auch nicht in die Kalkulation mit einfließen. Dafür braucht es eine Explainable AI, bei dem man sich nicht einfach nur mit dem Ergebnis zufrieden gibt.

Eine erklärbare KI hilft auch ihren Entwicklern

Auch für die Entwickler einer Künstlichen Intelligenz ist eine erklärbare KI vorteilhaft. Durch sie lässt sich feststellen, wo beispielsweise in den Trainingsdaten noch etwas verbessert werden muss. Dieses Beispiel einer Bilderkennung zeigt es beispielsweise sehr anschaulich.

Die Künstliche Intelligenz erkennt zwar Züge auf dem Motiv, aber bei der Erkennung legt sie vor allem Fokus auf die Schiene, weniger den Zug selbst. Bei einem Bild eines Zuges ohne Schiene, täte sich diese KI also vermutlich viel schwerer.

Allerdings lehrt einem das Beispiel auch einiges über Kontext. Würden wir nur den Zug ohne Schiene aus diesem Winkel sehen, könnte auch ein Mensch dieses Modell etwa mit einem Bus verwechseln. Die Schiene ist dagegen der Kontext, durch den wir nicht lange nachdenken müssen, um was für ein Fahrzeug es sich handelt. Ebenso ist der Bahnsteig und der unter Teil des Fahrzeuges relevant für die Bilderkennung.

Ein weiterer Schritt wäre nun, die KI mit Trainingsdaten zu füttern, in der etwa der Faktor Schiene kaum vorhanden ist. Funktioniert die Künstliche Intelligenz bereits mit diesen Daten, ist es gut – andernfalls lernt die KI dazu, Züge auch besser ohne Schienen zu erkennen.

Explainable AI und Vorurteile

Diese Überprüfbarkeit von Trainingsdaten ist auch ein großer Vorteil, wenn es darum geht, Vorurteile einer Künstlichen Intelligenz aus dem Weg zu räumen. Diese können nämlich entstehen, wenn man die Künstliche Intelligenz nur mit vorurteilsbehafteten oder unausgewogenen Trainingsdaten konfrontiert.

Eine Explainable AI allein hilft dabei aber nur bedingt. Schon im Vorfeld muss Sorge dafür getragen werden, dass die KI möglichst diverse und vorurteilsbefreite Daten erhält. Ein äußerst prominentes Beispiel dafür war Googles Bilderkennung. Google Photos geriet 2015 in Bedrängnis, als dunkelhäutige Menschen von der Bilderkennung als Gorillas klassifiziert wurden. Eine unausgewogene Trainingsgrundlage war einer der Gründe für diese katastrophale Fehleinschätzung. Mittlerweile ist Google allgemein darauf bedacht, sich auch in ihren Suchergebnissen deutlich diverser zu zeigen.

Die Auswertung einer erklärbaren KI hilft aber auch bei besserer Vorauswahl, die Trainingsdaten nochmal nachzujustieren. Außerdem ist es besser, Probleme fallen in einem Test auf, als dass der Shitstorm in den sozialen Medien losbricht.

Wie wichtig auch Gruppierung von Informationen sind zeigte übrigens eine Analyse von 2016 bei Facebook. Dieser Analyse nach, wurde im Unternehmen Code von weiblichen Programmierinnen 35 Prozent öfter abgelehnt. Was zunächst nach einer Geschlechtsdiskriminierung klingt, stellte sich weitgehend als Interpretationsproblem heraus. Da das Unternehmen erst in den letzten Jahren verstärkt Frauen einstellte, sind viele der erfahrensten Programmierer*innen männlich. Bei gleicher Altersgruppe soll sich die Ablehnung des Codes nach Geschlecht kaum unterschieden haben.

Image by phonlamaiphoto via Adobe Stock

Artikel per E-Mail verschicken